OpenAIの「ChatGPT」などAIを活用した大規模言語モデルは、人間からの質問に対してAIが自然な回答を生成することから、文章の創作に応用するユーザーがいる一方、学生がレポート制作に使うなど「手抜き」に利用されるケースも。

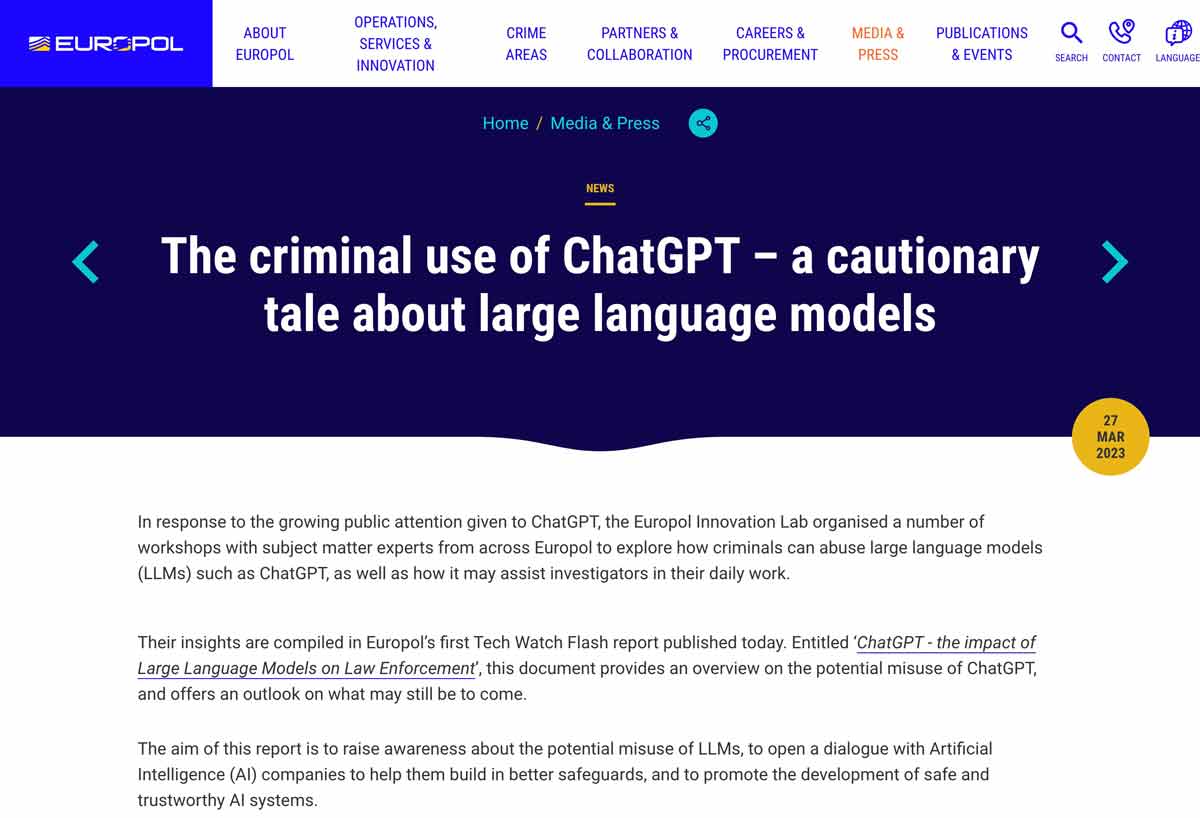

使い方によって善悪双方の側面がある存在ですが、犯罪に悪用されることはないのでしょうか。欧州刑事警察機構(ユーロポール)は2023年3月28日付で、ChatGPTが犯罪に利用される可能性についての研究レポートを公開しました。

オランダのデン・ハーグに本拠を置くユーロポール。欧州各国の警察機関が情報を共有し、重大な国際犯罪に対処するために設立されました。

組織の中には犯罪研究をしている部門があります。そのうちのイノベーション研究所が、ChatGPTのような大規模言語モデル(LLM)を犯罪組織が悪用する可能性、また捜査官が日常業務で役立てられる可能性について、研究報告「ChatGPT-the impact of Large Language Models on Law Enforcement(大規模言語モデルが法執行に与える影響)」をまとめました。

一般公開されたものはダイジェスト版で、より詳しい報告は各国の警察など法執行機関のみに提供されます。報告では、ChatGPTのような大規模言語モデルが悪用されやすい犯罪類型として、3つを挙げています。

■ 悪用されやすい犯罪類型3つ

【詐欺】

まず挙げられているのは詐欺。

ChatGPTはユーザーの要求に応じて「もっともらしい」文章を生成するため、偽サイトや偽メールによるフィッシング詐欺、振り込め詐欺に悪用されると、本物と誤認して被害に遭いやすくなる可能性があります。

【偽情報】

そして、人間にとって違和感のない文章を自動的に生成する能力は、特定のプロパガンダや偽情報を拡散するのに役立ちます。

世論を誘導し、意図した方向へ社会を変えてしまいかねず、非常に危険だといえるでしょう。

【サイバー犯罪】

また、ユーザーの要求に応じて生成されるのは文章だけとは限りません。

プログラムのソースコードも同じ「文字列」ですから、うまく誘導するとプログラミング知識がそれほどなくても悪意あるプログラムやコードを生成することも不可能ではなく、サイバー犯罪やサイバーテロに悪用される可能性があります。

■ 各国の法執行機関がAIの進化に対応してゆくには

現在のところ、AIには「意志」がありませんから、使い方によっては重大な犯罪に悪用されるかもしれません。各国の法執行機関では、AIの進化に対応して有効な対策を練るため、開発元と密接な協力関係を築くことが重要だとしています。

AIの進歩はまさに日進月歩。近い将来、本当にAIを悪用した重大な国際犯罪が発生するかもしれず、その可能性に備えておくことが必要なのかもしれません。

研究報告書「ChatGPT-the impact of Large Language Models on Law Enforcement」はユーロポールのサイトにて、PDFがダウンロードできるようになっています。

🚨📄 New #TechWatch flash report: “ChatGPT – the impact of Large Language Models on Law Enforcement.”

➡️ The report provides an overview on the potential criminal misuse of LLMs and discusses the impact they might have on law enforcement.

Read it here ⤵️https://t.co/M8X8EQis26 pic.twitter.com/8ZZoiLsdzX

— Europol (@Europol) March 27, 2023

<出典・引用>

欧州刑事警察機構(ユーロポール) プレスリリース

(咲村珠樹)